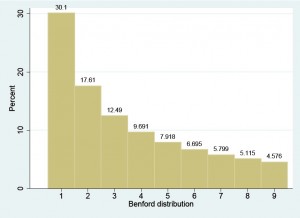

Simon Newcomb, un astronome et mathématicien du XIXème siècle, avait remarqué que les tables de logarithmes étaient plus usées au niveau des premières pages. Il en a déduit que les nombres qui nous entourent commencent par un premier chiffre plus souvent petit que grand. Il a postulé une loi de répartition de ces premiers chiffres significatifs (Cf. illustration graphique) et a publié son travail en 1881. Ce phénomène a été indépendamment redécouvert et approfondi par le physicien Franck Benford en 1938. Benford a mené un travail minutieux de collecte de données de diverses sources (numéros de rue de personnes tirées au hasard dans l’annuaire, hauteurs d’immeubles, nombres lus dans le magazine Reader’s Digest). Beaucoup de ces jeux de données semblaient distribués selon la loi de répartition, mais pas tous. Le plus frappant, c’était que l’union de ces jeux de données collait quasi parfaitement, elle, à cette loi.

Il a fallu quelques décennies aux mathématiciens pour formaliser et mieux comprendre cette loi, appelée désormais loi de Benford. Sans rentrer dans sa définition mathématique précise, on peut en décrire quelques propriétés. La première, établie par Roger Pinkham en 1961, est qu’elle est stable par changement d’unités de mesure : les hauteurs obtenues suivent toujours la loi de Benford, qu’on mesure les immeubles en mètres ou en pieds. Cela constitue une première indication du côté universel et naturel de cette loi.

Une seconde propriété a été observée par Benford lui-même et modélisée par les mathématiciens Theodore P. Hill dans les années 1990 d’une part et Elise Janvresse et Thierry de la Rue dans les années 2000 d’autre part. Elle énonce que fusionner des jeux de données différents et n’ayant rien à voir entre eux permet en général d’obtenir un jeu de données agrégé suivant cette loi. Cela forme une deuxième indication du côté universel et naturel de cette loi.

Enfin, la troisième propriété permet de comprendre pourquoi on observe des jeux de données suivant la loi de Benford dans les activités humaines, notamment économiques. Persi Diaconis a continué, dans les années 1970, une lignée de travaux montrant que les suites de nombres obtenus par accroissements multiplicatifs (éventuellement aléatoires) étaient presque toutes distribuées selon la loi de Benford, comme par exemple, en économie, la suite des PIB, année après année, ou de toute autre quantité influencée multiplicativement par l’inflation et la croissance.

Cette dernière propriété permet de construire des tests d’authenticité (de non-manipulation) de données économiques : il suffit de voir si les données semblent raisonnablement distribuées selon une loi de Benford, ce que l’on peut effectuer via un test dit d’ajustement du chi-2. L’idée a d’abord germé dans le domaine de l’audit et de la comptabilité, à la suite des travaux de Mark J. Nigrini dans les années 1990 et leur application avec succès par les autorités judiciaires de la ville de New York. Elles ont pu détecter et faire condamner sept entreprises falsifiant des nombres dans leurs bilans comptables. Il est également possible d’appliquer cette méthodologie à la balance des paiements des Etats (et c’est ainsi que j’en suis venu à fréquenter la loi de Benford).

Brève rédigée par Gilles Stoltz (Ecole normale supérieure – HEC Paris), d’après ses travaux avec Tomasz Michalski (HEC Paris).

Pour en savoir plus :

- Do countries falsify economic data strategically? Some evidence that they might, The Review of Economics and Statistics, à paraître, 2013 [En anglais].

- Quel est le début de ce nombre ?, Elise Janvresse, Images des Mathématiques, CNRS, 2009.

- I’ve Got Your Number, Mark J. Nigrini, Journal of Accountacy, mai 1999 [En anglais].

Crédits Images :

- Fig 1) Wikimedia Commons.

- Fig 2) G. Stoltz.

2 Commentaires