Parmi les questions qui agitent les scientifiques à propos du changement climatique revient continuellement celle de la comparaison de la variabilité climatique actuelle avec celle du passé. A l’échelle du dernier millénaire, les mesures directes ne sont pas disponibles, il faut donc les reconstruire. Cependant, depuis le XIXèmesiècle, nous disposons de nombreuses longues séries d’observations instrumentales. Mais leur qualité doit être étudiée au préalable.

Par définition, une série d’observations météorologiques est dite homogène lorsque les conditions de mesure n’ont pas varié au cours du temps.

L’homogénéité – ou plutôt l’absence d’homogénéité – des longues séries instrumentales en climatologie est un problème connu depuis longtemps. Le déplacement des postes climatologiques au cours du temps, la modification des sites de mesure, de l’instrumentation, des méthodes de calcul des paramètres météorologiques et les changements d’observateurs, parmi tant d’autres, vont se traduire par autant de sauts dans les séries de données. Or, ces ruptures artificielles peuvent être du même ordre de grandeur que les phénomènes qu’on cherche à mettre en évidence dans les séries climatiques, comme les tendances, les cycles, etc. Leur correction est donc indispensable avant toute étude climatique sérieuse.

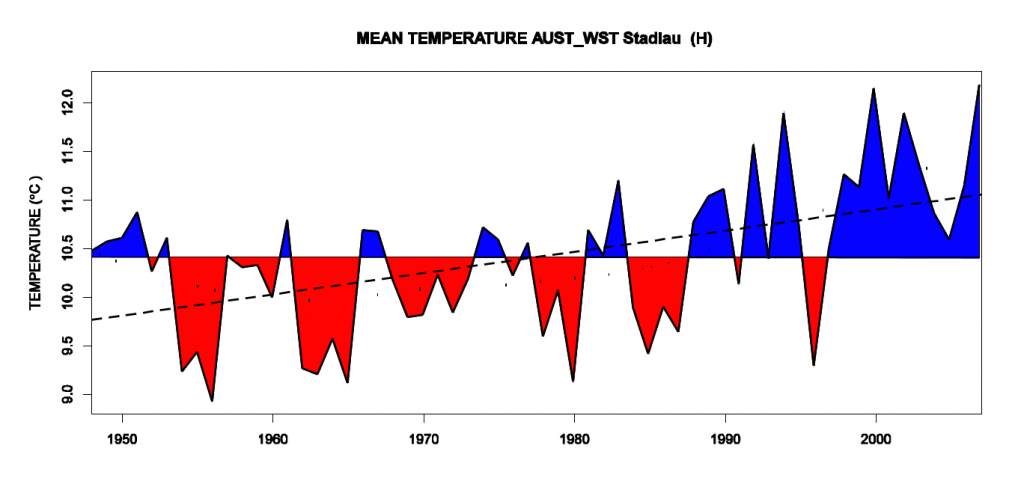

Si l’on regarde la série de Salzbourg (Autriche), elle ne semble pas spécialement perturbée de prime abord.

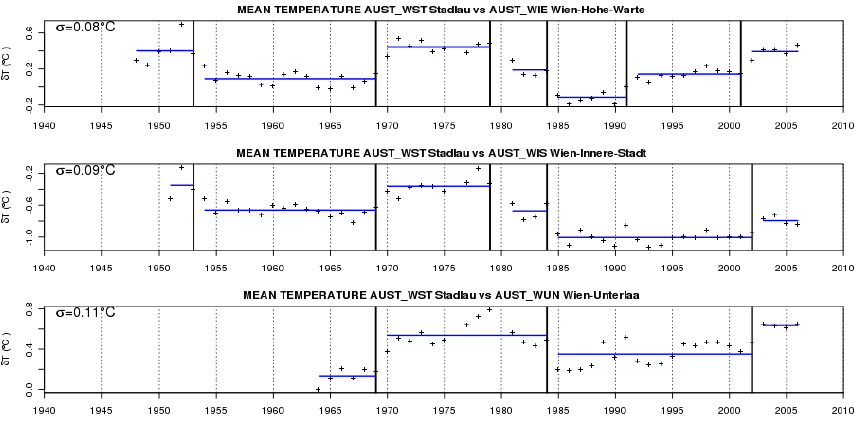

Théoriquement, cette série devrait afficher à peu près la même variabilité que les séries relevées dans la même région, comme à Munich, Innsbruck ou Kremsmünster. Pourtant, lorsqu’on la compare à ces séries en calculant simplement la différence des séries annuelles avec la série de Salzbourg, on met en évidence un certain nombre de sauts artificiels.

Ces changements sont dus à des déplacements de la station météorologique, à des changements d’instrumentation, voire à des modifications de l’heure des relevés.

La détection de ces ruptures requiert des techniques de programmation dynamique et de vraisemblance pénalisée permettant d’estimer au mieux le nombre et la position de ces ruptures. Ces techniques statistiques sont utilisées dans de nombreux domaines, tels que le traitement du signal, l’économétrie ou la biologie (segmentation de l’ADN).

A partir de ces informations, les données sont ensuite corrigées, ou « homogénéisées », afin d’éliminer autant que possible l’effet des changements, qui sont assez sensibles dans l’exemple ci-dessus : une analyse directe de la série aurait été assez largement faussée.

Disposer de séries fiables est une étape indispensable pour comprendre la variabilité climatique. L’obtention de longues séries de données homogènes est un processus laborieux, qui nécessite le recensement et la saisie de données anciennes, l’exploitation des archives des postes, et l’utilisation de techniques statistiques permettant de détecter et corriger l’effet des changements dans les conditions de mesure.

Brève rédigée par Olivier Mestre (Météo France), d’après les travaux de Franck Picard (Univ Lyon 1-CNRS), Emilie Lebarbier, Stéphane Robin, (AgroParisTech-INRA), Brigitte Dubuisson (Météo France).

Pour en savoir plus :

- Benchmarking homogenization algorithms for monthly data, Climate of the Past, Copernicus Publications on behalf of the European Geosciences Union [en anglais].

- Un site sur l’homogénéisation [en anglais].

- Brèves connexes : « Les cernes d’hier », « Reconstruction du climat du dernier millénaire », « Réchauffement climatique ou fin d’une période glaciaire ? ».

Crédits Images :

- Archives Météo-France.

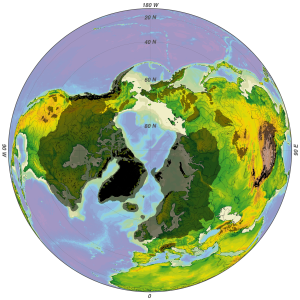

- Fig. 1 : source : projet ECA&D.

- Fig. 2 : Olivier Mestre.

3 Commentaires